Lựa Chọn Mô Hình AI Phù Hợp Cho Công Việc

Trợ lý AI đã âm thầm trở thành một phần không thể thiếu trong công việc hàng ngày. Chúng soạn thảo thư trả lời, tóm tắt các chuỗi email dài, dịch nội dung cho các nhóm toàn cầu và biến những ghi chú thô sơ thành thứ bạn thực sự muốn gửi đi. Nhưng câu hỏi “mô hình nào tốt nhất?” lại khó trả lời một cách chính xác trong thực tế công việc. Nhận thức về thương hiệu, sự khác biệt về giao diện người dùng và một trải nghiệm tồi tệ cũng có thể nhanh chóng làm sai lệch ý kiến.

Vì vậy, chúng tôi đã tiến hành một thử nghiệm nội bộ nhỏ. Trong bốn tuần, các nhân viên của Synology trên toàn thế giới đã sử dụng các tính năng AI bên trong Synology Office và MailPlus, bộ phần mềm Synology Office Suite cho phép các tổ chức kết nối hệ thống quản lý vòng đời ứng dụng (LLM) mà họ lựa chọn trong khi vẫn giữ bí mật nội dung thông qua lớp ẩn danh. Mỗi tuần, những người tham gia được chỉ định ngẫu nhiên một trong bốn mô hình hàng đầu (Claude, Gemini, GPT hoặc Grok) và thử nghiệm được tiến hành một cách khách quan: không ai biết họ đang sử dụng mô hình nào.

Chúng tôi cố tình tránh biến điều này thành một bài kiểm tra chuẩn trong phòng thí nghiệm vì muốn có phản hồi thực tế từ các hoạt động hàng ngày. Vì vậy, xin lưu ý nhanh: các câu hỏi không được chuẩn hóa và các nhiệm vụ không được kiểm soát. Tuy nhiên, mọi người đã thực hiện công việc thực tế, chẳng hạn như cải thiện bản nháp email, kiểm tra ngữ pháp trong báo cáo, dịch các bài thuyết trình bán hàng, và nhiều hơn nữa. Sau đó, họ trả lời một cuộc khảo sát ngắn hàng tuần. Trong suốt bốn tuần, chúng tôi đã thu thập được 147 phản hồi từ hàng chục nhóm.

Những gì chúng tôi tìm thấy

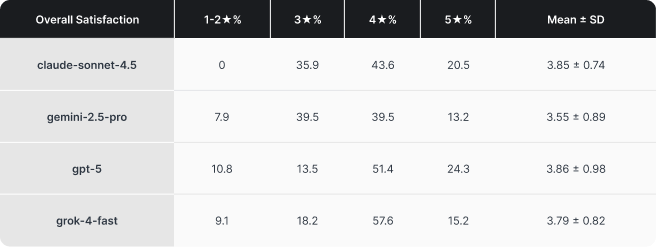

Ba ứng viên hàng đầu có điểm số rất sát nhau. Claude, Grok và GPT chỉ chênh lệch nhau vài phần trăm điểm trên thang điểm chất lượng tổng hợp của chúng tôi. Như dự đoán đối với các mô hình LLM tiên tiến, sự khác biệt sẽ tương đối nhỏ. Điều thú vị hơn là mặc dù GPT nhỉnh hơn Claude một chút về điểm số cuối cùng, nhưng nó lại nhận được nhiều phản hồi tiêu cực hơn đáng kể.

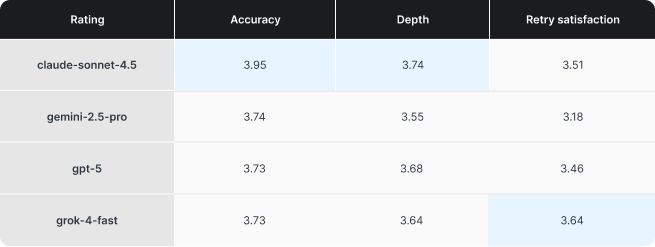

Điểm mạnh của từng mô hình rõ ràng hơn so với thứ hạng tổng thể. Claude dẫn đầu về Độ chính xác và Độ sâu, một hồ sơ mạnh mẽ cho công việc mà tính chính xác và giải thích là quan trọng nhất. Grok nổi bật ở khía cạnh mà chúng tôi gọi là sự hài lòng khi thử lại, cũng có thể được hiểu là khả năng tuân theo hướng dẫn của mô hình. Điều đó rất quan trọng bởi vì việc liên tục trao đổi qua lại là một trong những cách nhanh nhất để biến một trợ lý từ hữu ích thành gây khó chịu. Gemini không xuất sắc ở bất kỳ chỉ số cụ thể nào, mặc dù điều này có thể là do nó là mô hình lâu đời nhất trong bài kiểm tra này (Gemini 3 không có sẵn khi chúng tôi bắt đầu thử nghiệm). Một lần nữa, đây không phải là một bài kiểm tra khoa học, nhưng kết quả vẫn rất thú vị.

Nơi mà ma sát xuất hiện

Những phản hồi và nhận xét định tính mà chúng tôi nhận được đã cho thấy một bức tranh nhất quán về những yếu tố thực sự làm chậm tiến độ công việc của mọi người:

- Việc tuân thủ hướng dẫn kém , phải diễn đạt qua quá nhiều lần để nắm bắt đúng giọng điệu, cấu trúc và độ chính xác.

- Những câu trả lời về mặt kỹ thuật thì đúng nhưng quá dài hoặc quá bảo thủ , gây thêm công việc và làm giảm thời gian tiết kiệm được.

- Các vấn đề về kỷ luật ngữ cảnh , trong đó mô hình đưa ra các giả định từ ngữ cảnh (không chính xác) (ví dụ: không hiểu rằng cuộc họp đã được thay đổi từ thời điểm này sang thời điểm khác trong một chuỗi email tiếp theo).

Thật khó để định lượng và chấm điểm một số yếu tố này, nhưng chính chúng lại là những gì quyết định liệu trợ lý ảo có giúp tiết kiệm thời gian hay chỉ là một chiêu trò. Ngay cả trong một thử nghiệm mù, những khác biệt về hành vi vẫn được thể hiện rõ ràng.

Một số mô hình mặc định tạo ra bản nháp đầu tiên dài hơn mặc dù được yêu cầu viết ngắn gọn, gây khó khăn trong quy trình viết văn bản và email, nơi mà các thông điệp ngắn gọn và rõ ràng quan trọng hơn. Một số mô hình lại nghiêng về những câu trả lời an toàn hơn, thận trọng hơn trong các tình huống mơ hồ, làm giảm khả năng mô hình đưa ra điều gì đó gây tranh cãi hoặc có khả năng không chính xác, nhưng lại gây khó chịu cho người dùng muốn có một khuyến nghị hoặc tuyên bố rõ ràng.

Trị giá

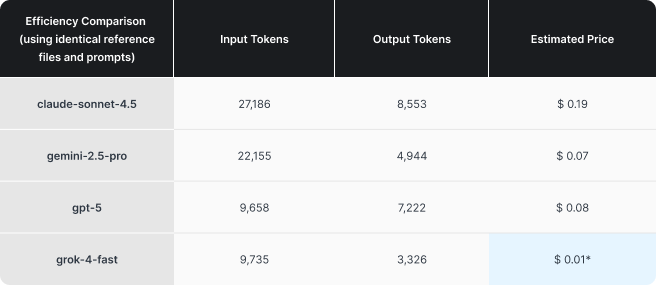

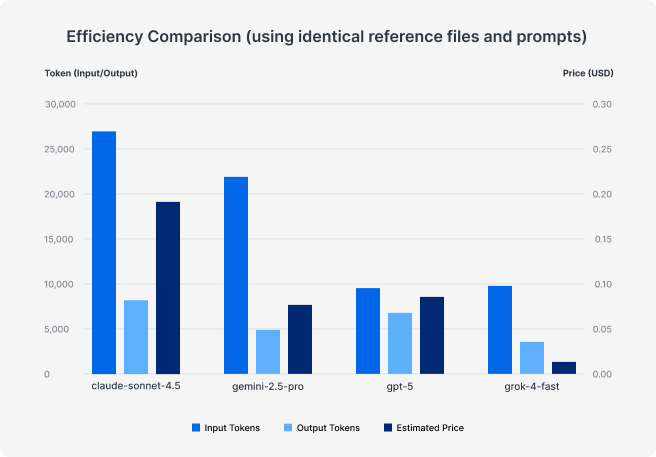

Một lý do khác khiến chúng tôi thực hiện chương trình thí điểm này là vì việc dự đoán giá cả thực tế khá khó khăn. Hành vi sử dụng token thay đổi đáng kể giữa các mô hình, và chi phí thực tế có thể nhanh chóng khác biệt so với dự đoán chỉ dựa trên tỷ lệ mỗi token.

Trong nhật ký sử dụng, chúng tôi nhận thấy sự khác biệt rõ rệt về hiệu quả sử dụng token của từng mô hình, ngay cả khi sử dụng cùng một tập tin nhắc nhở và tham chiếu. Các thử nghiệm của chúng tôi được thực hiện với tính năng suy luận hầu hết bị vô hiệu hóa hoặc được đặt ở mức tối thiểu, nhưng cách thức hoạt động của một mô hình vẫn có thể khác nhau đáng kể, đặc biệt là do bản chất phi xác định của các mô hình tuyến tính logic (LLM).

Chúng tôi đã tiến hành một thử nghiệm nhỏ riêng biệt để đánh giá hiệu quả, nhưng kết quả phù hợp với kết quả thử nghiệm chính trên toàn tổ chức. Nói một cách đơn giản, giá cả và hiệu quả có sự khác biệt đáng kể. Mặc dù Claude thường nhận được phản hồi tốt nhất, nhưng chúng ta vẫn phải tự hỏi liệu nó có đáng giá hơn gấp đôi so với Gemini hay GPT hay không? Và việc thêm Grok vào so sánh cũng không công bằng.

*Làm tròn lên

Tóm lại: Chi phí có thể thay đổi rất nhiều. Giống như khi làm việc với các nhà cung cấp CNTT, điều quan trọng là phải theo dõi và thường xuyên kiểm tra chất lượng so với chi phí của các dịch vụ bạn sử dụng. Các mô hình AI hiện đang được cải thiện với tốc độ chóng mặt, điều này càng làm cho việc theo kịp trở nên quan trọng và có lợi hơn.

Điều này có ý nghĩa gì đối với các công ty triển khai AI?

Kết luận chính rất đơn giản: AI không phải là thứ có thể cài đặt rồi quên đi. Thử nghiệm của chúng tôi chỉ kéo dài bốn tuần, và ngay cả trong khoảng thời gian đó, các nhà cung cấp đã tung ra những bản cập nhật quan trọng làm thay đổi hành vi, chất lượng và chi phí. Nếu bạn đang triển khai AI vào các quy trình làm việc cốt lõi, bạn cần một khung phần mềm đơn giản để liên tục kiểm tra xem các giả định của bạn có còn đúng với môi trường hiện tại hay không.

Trí tuệ nhân tạo (AI) đã cho thấy tiềm năng thực sự trong các công việc đòi hỏi kiến thức chuyên môn thường nhật, đặc biệt là viết, tóm tắt và dịch thuật. Điều quan trọng nhất là số lần thử lại, độ chính xác và liệu nhân viên có đủ tự tin để gửi bản thảo với số lần chỉnh sửa tối thiểu nhằm thực sự tiết kiệm thời gian hay không.

Cuối cùng, điều đáng chú ý là điều gì đã giúp cho loại đánh giá này trở nên khả thi: chúng tôi đã chạy thử nghiệm bên trong Synology Office và MailPlus, với lớp ẩn danh được kích hoạt giữa nội dung người dùng và nhà cung cấp mô hình. Năng suất kinh doanh phụ thuộc vào nhiều yếu tố hơn là chỉ LLM, mà còn vào việc lựa chọn một hệ thống tích hợp với quy trình làm việc của nhân viên và tuân thủ các chính sách bảo mật dữ liệu của công ty. Đây là cốt lõi của Synology AI Console, một nền tảng được thiết kế để giúp các tổ chức phát triển song song với hệ sinh thái AI trong khi vẫn giữ an toàn cho dữ liệu của họ.

Bạn đã sẵn sàng thu hẹp khoảng cách giữa năng suất nhờ trí tuệ nhân tạo và bảo mật dữ liệu chưa?

Xem thêm